本記事はGrafana Labs blog の記事を翻訳し転載しています

Yasir Ekinci, Ben Sully – 2024-12-18

Grafana Labsのミッションは常に、ユーザーが独自の可観測性ソリューションを構築するために必要なツールを提供することです。私たちの重要な企業フィロソフィーは、あなたのニーズに最も適したツールや技術を選択できるようにすることです。Grafna Labは、この使命を具現化しています。

このブログでは、このフィロソフィーを実際に反映したLLM プラグインのアップデートを共有したいと思います。今年初めの0.10.0 リリースでは、Grafana全体の大規模な言語モデルへの一元的なアクセスを提供するGrafana LLMプラグインが、オープン ウェイト モデル とOpenAIではないプロバイダーをサポートするようになりました。これにより、パフォーマンス、プライバシー、およびコストの面でニーズに最適なLLMとプロバイダーをより柔軟に選択できるようになりました。

Grafana LLM プラグインの概要

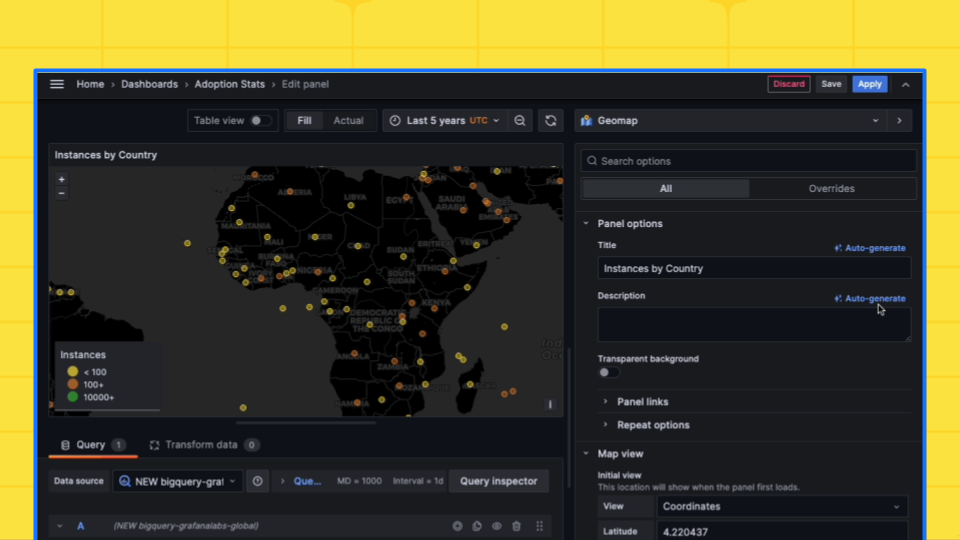

Grafana LLMプラグイン(現在、Grafana OSS、Grafana Enterprise、Grafana Cloudでパブリックプレビュー中)は、生成AIを活用してワークフローを簡素化します。より具体的には、このプラグインはLLMを活用して次のようなことができます:

- ダッシュボードやパネルに、よりわかりやすいタイトルで注釈を付ける

- インシデント サマリーの自動生成する

- ログのパターンをより人間にわかりやすく説明する

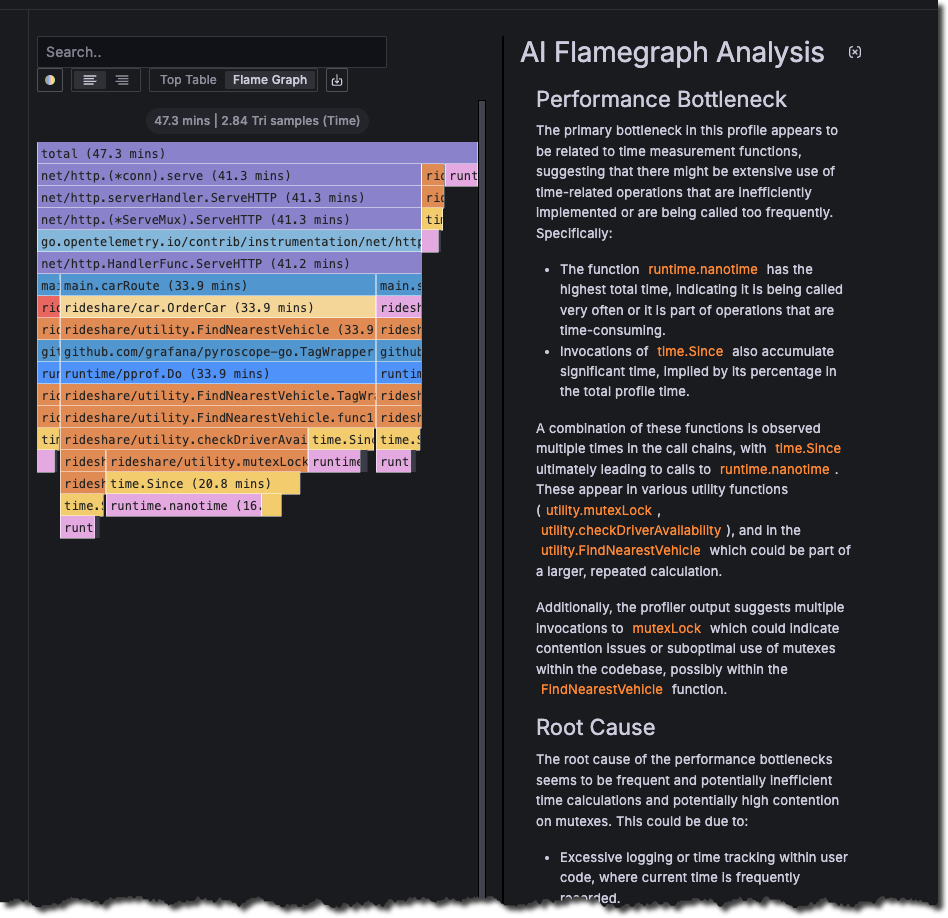

- Flame graph AIで複雑なフレームグラフのプロファイルを分析する(以下を参照)

0.10.0リリースで行われたアップデートにより、どのLLMまたはLLMプロバイダーを選択しても、コスト、パフォーマンス、プライバシーのバランスを考慮して最適なものを選択できるようになり、これらの機能がより利用しやすくなりました。

LLM の統合サポート

当初、GrafanaのLLM機能は、強力なGPTモデルを活用したOpenAIのモデルに限定されていました。これらのモデルは注目に値しますが、柔軟性のニーズを認識していました。最新のアップデートでは、OpenAI互換APIの背後にあり、システムプロンプトをサポートしている限り、任意のモデルを自由に統合できるようになりました。

つまり、次のような利点があります:

- セルフホストモデル : Llama 3 のような強力なオープンソースモデルを使用し、それらを独立してデプロイすることで、データとモデルの管理を完全に制御できます。

- 代替 LLM プロバイダーのサポート : LiteLLMなどのOpenAI互換プロキシを使用すると、GoogleのGeminiやAnthropicのClaudeなどのさまざまなプロバイダーのモデルを、どのクラウドサービスを使っていても利用することができます。

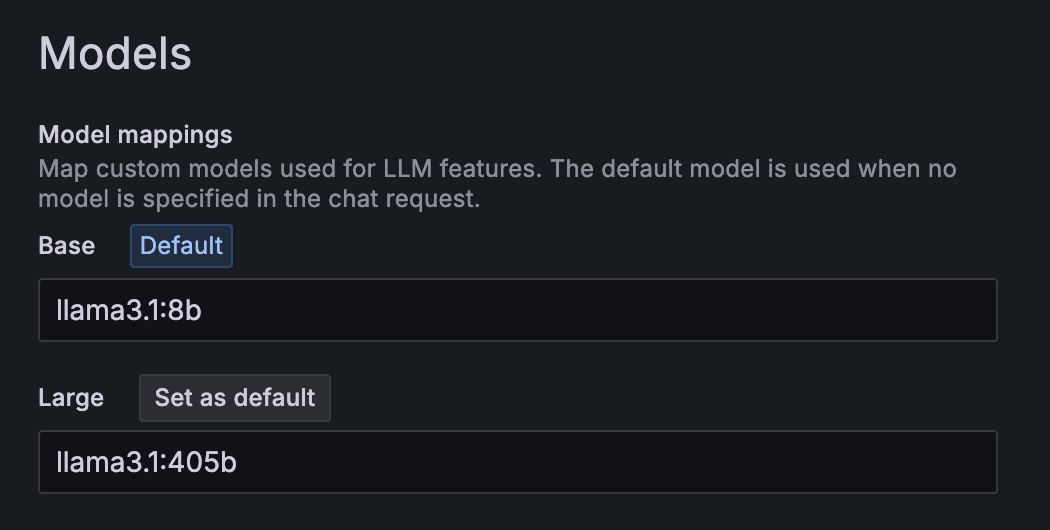

この移行を可能な限りシームレスにするために、費用対効果の高いLLM完了のためのベースモデル(例:gpt-4o-mini)と、より高度な機能やより大きなコンテキストウィンドウを必要とするユースケース向けのラージモデル(例:gpt-4o)の2つの簡略化されたオプションを提示しています。Grafana 管理者は、これらのデフォルトをオーバーライドして、コスト、パフォーマンス、プライバシーのバランスが取れたカスタムモデルを選択できます。

LiteLLM などの一部の OpenAI 互換 API プロキシは追加のルーティング機能を備えており、独自のニーズと要件に応じて、異なるプロバイダー(独自のセルフホスト プロバイダーを含む)の異なるモデルをBaseモデルまたはLargeモデルのいずれかに使用することができます。

カスタム LLM プロバイダーの使用を開始する

代替プロバイダーまたはセルフホスト LLM モデルを使用するには、以下の簡単な手順に従ってください。

- プラグインをインストールする。

- LLM APIを設定する: vLLM、Ollama、LM Studio、LiteLLM などの OpenAI 互換 API サーバーがあることを確認します。

- プラグインを設定する:

- プラグインの設定で[Use your own OpenAI Account]を選択します。

- OpenAI API URL にセルフホストAPIのアドレスを設定します。 (例: http://vllm.internal.url:8000/)

- [Model Settings] > [Model mappings] で、

BaseモデルとLargeモデルを指定して、カスタムモデルをマッピングします。(例:meta-llama/Meta-Llama-3-8B-Instruct)

以上です!これで、選択したモデルでGrafanaのLLMを利用した機能を楽しむことができます。さらに、必要に応じて、使用するデフォルトモデルをBaseまたはLargeに変更するオプションが追加されました。

OpenAIでない LLMをGrafanaでベンチマーク

独自のLLMを導入するための扉を開くにあたり、Open AIでないプロバイダーを利用するオプションを使用しても、GrafanaのAI機能が期待どおりに機能することを確認したいと考えました。これは言うは易く行うは難しで、プロンプトが多様なプロバイダーやオープンなLLMモデル間で一貫して機能することを保証するのは容易ではないからです。

テストアプローチの一環として、いくつかの人気のあるLLMで私たちのAI機能に対してベンチマークを行ったところ、現在のプロンプト構造は、複数のシステムプロンプトを使用しているため、一部のモデル(特にllama3)では信頼できないことがわかりました。さまざまなアプローチをテストできたことで、私たちはそれを改善し、どのモデルを選んでも、機能がベストの状態で機能することが確認できました。

ベンチマーク結果

| モデル | パネルの説明 N=841 | パネルタイトル N=841 | ダッシュボードのタイトル N=506 |

|---|---|---|---|

| gemini-1.5-flash | 78.1% | 82.0% | 67.2% |

| claude-3.5-sonnet | 78.4% | 80.5% | 68.7% |

| gpt-4o-2024-05-13 | 77.8% | 81.3% | 66.1% |

| gpt-4o-mini-2024-07-18 | 78.0% | 80.7% | 66.8% |

| gpt-4-turbo-2024-04-09 | 77.6% | 79.4% | 66.9% |

| gpt-3.5-turbo-0125 | 76.3% | 77.8% | 63.6% |

| llama3:8b-instruct | 73.0% | 73.1% | 65.0% |

| llama3.1:8b-instruct (AWQ) | 76.7% | 70.9% | 63.1% |

| llama3:8b-instruct (pre-fix) | 59.2% | 58.5% | 64.1% |

予想通り、大型モデルはより優れたパフォーマンスを発揮します。また、小型モデルもサポートすることで、コストとパフォーマンスをトレードオフするための柔軟性とオプションを提供しています。

GrafanaにおけるLLMの今後は?

今後も、Grafana の開発者により多くの LLM 機能を提供し、引き続き私たちの企業フィロソフィーを実現していきたいと考えています。

私たちが追求したいと考えている機能の 1 つは、関数呼び出しとツールの統合を可能にすることです。これにより、開発者は LLM を使用して Grafana と対話して、たとえば、新しいインシデントを作成したり、ダッシュボードを更新したりできるようになります。

最近の Grafana Labs ハッカソン プロジェクトでは、モデル コンテキスト プロトコル (MCP) を試し、この機能などを提供する Grafana MCP サーバーを作成しました。これにより、ユーザーは Claude Desktop や Zed などの互換性のある MCP クライアントから Grafana インスタンスについてディスカッションできます。さらに、Grafanaと対話するためのよりエージェント的なアプローチへの道が開きます。例えば、SlackからGrafanaインスタンスとチャットをして、関連するダッシュボードを検索したり、インシデントにコメントを追加したり、Sift の 調査を開始したりできるアシスタントを想像してみてください。

これからも引き続きGrafana で LLM 機能を構築していきますので、詳細をご期待ください。

原文:Grafana LLM plugin updates: choose the large language models and providers that work best for you